교육/연구

학문 읽는 AI, 이제 한국어도 OK

작성자기획과 조회수166 등록일2025-11-06

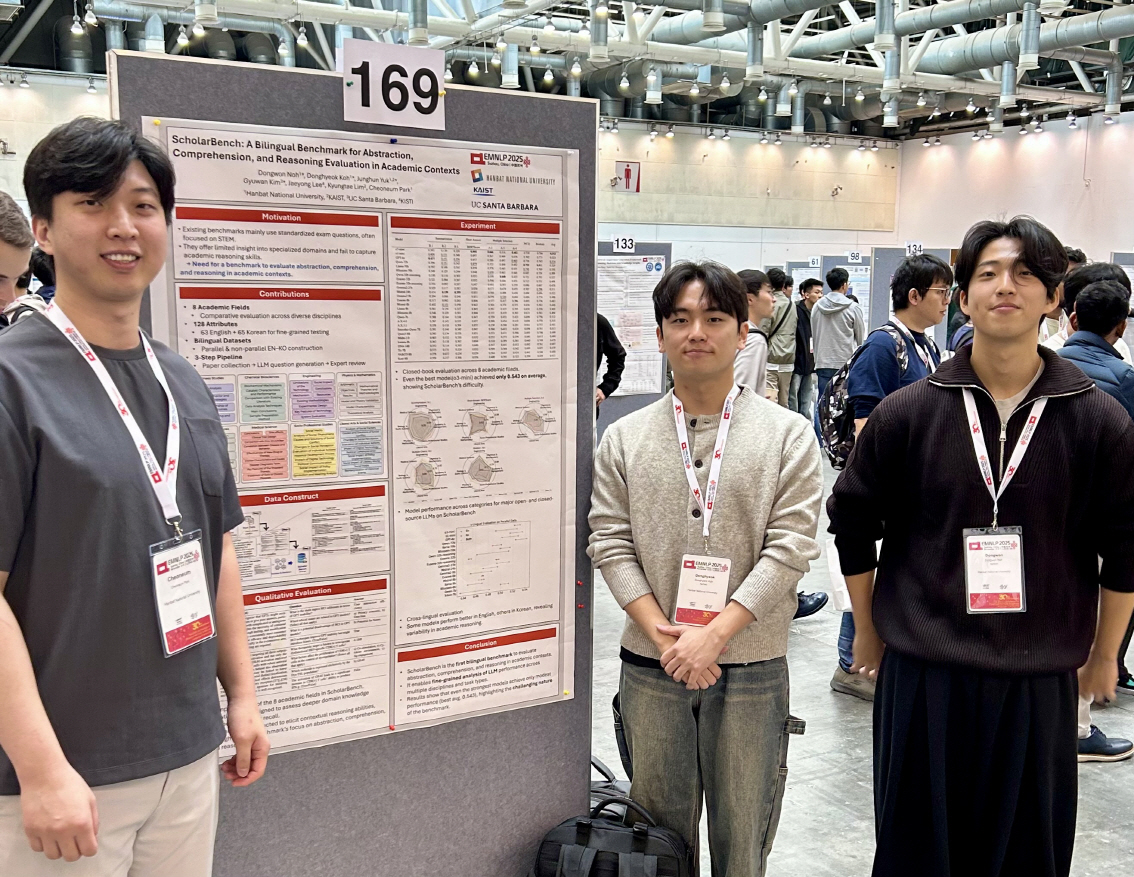

- 컴퓨터공학과 노동원 석사과정과 고동혁 학부생, 공동 1저자 논문 ‘EMNLP 2025’에서 이중언어 학술 추론 벤치마크 발표

□ 우리 대학 컴퓨터공학과 노동원 석사과정과 고동혁 학부생(박천음 교수 연구팀)이 거대언어모델(LLM)의 ‘학문적 사고력’을 평가하기 위한 새로운 국제 벤치마크인 ScholarBench를 개발하고, 이를 자연어처리 분야 최고 학회 중 하나인 ‘EMNLP 2025’에서 포스터로 발표했다.

○ 이번 연구는 한국어와 영어 두 언어로 구성된 학술 추론 데이터셋을 제안하며, 거대언어모델이 단순한 질의응답을 넘어 실제 학문 텍스트를 이해하고 추론할 수 있는지를 측정할 수 있도록 설계됐다.

○ 본 논문은 ‘ScholarBench: A Bilingual Benchmark for Abstraction, Comprehension, and Reasoning Evaluation in Academic Contexts’라는 제목으로 ACL Anthology(https://aclanthology.org/2025.findings-emnlp.465/)에 공개됐다.

□ 학문 수준의 이해, 추상화, 추론을 측정하는 새로운 기준

○ 연구팀은 기존의 일반적인 언어모델 벤치마크들이 주로 문장 완성, 단순 질의응답, 또는 상식적 추론에 초점을 두고 있어 ‘학문적 사고의 계층적 구조’를 반영하지 못한다는 점에 주목했다.

○ 이를 해결하기 위해 ScholarBench는 추상화(Abstraction), 이해(Comprehension), 추론(Reasoning)의 세 가지 인지적 단계에 따라 문항을 구성하고, 자연과학․응용과학․사회과학․인문학 등 8개 분야를 포함해, 실제 논문 수준의 복잡한 개념 관계와 논증 구조를 반영했다.

○ 특히 영어와 한국어 두 언어 버전을 동일한 주제와 구조로 제작함으로써, 모델의 언어 간 사고력 균형과 학술적 추론의 일관성을 동시에 평가할 수 있도록 설계된 점이 큰 특징이다.

□ 연구팀은 최신 언어모델들을 ScholarBench로 평가한 결과, GPT-4o와 Claude-3 같은 상용 모델조차 학문적 추론 단계에서 0.54 수준의 평균 점수에 머무른다고 밝혔다.

○ 이는 거대언어모델이 표면적 이해에는 강하지만, 논증 구조나 개념 간 관계 추론에서 한계가 있음을 보여주며, 따라서 본 벤치마크는 단순 성능 경쟁이 아니라, 모델의 ‘사고 과정’ 자체를 들여다보는 평가 틀로서 중요한 의미를 가진다.

□ 국립한밭대, “한국어 학문 AI의 새로운 표준을 만들겠다”

○ 이번 연구를 주도한 박천음 교수 연구팀은, 한국어를 포함한 비영어권 학문 데이터에 특화된 AI 연구의 필요성을 강조하면서, “ScholarBench는 단순한 벤치마크를 넘어, 한국어 학술 데이터를 이해하고 생성할 수 있는 AI의 발전 방향을 제시하고 있으며, 한국 연구자들이 국제적 수준의 AI 평가 생태계에 적극 참여할 수 있는 기반이 될 것”이라고 밝혔다.

□ 이번 연구에는 국립한밭대학교 컴퓨터공학과 노동원 석사과정, 고동혁 학부생, KAIST 문화기술대학원 육정훈 석사과정과 캘리포니아주립대학교 산타바바라(UCSB) 김규완 박사과정이 공동 제1저자로, 박천음 교수가 교신저자로 참여했으며,

○ 연구팀은 중국 쑤저우에서 열린 ‘EMNLP 2025’ 학회 포스터 세션에서 ScholarBench의 구조, 설계 원리, 평가 결과를 발표했다.

○ 이번 연구는 LLM 시대에 “AI가 인간처럼 학문을 읽고 사고할 수 있는가”라는 근본적 질문에 대한 실증적 접근이라는 점에서 의미가 크며, 한국어가 포함된 이중언어 벤치마크를 통해 비영어권 언어의 학술적 표현과 사고 구조를 평가할 수 있는 첫 시도로 평가된다.